Menschen irren. Systematische Fehler und falsche Annahmen prägen Entscheidungen, das alltägliche Leben und zwischenmenschliche Beziehungen. Auch hinsichtlich des Umgangs mit Risiken bedarf es einer kritischen Reflexion darüber, inwieweit der Mensch sich in die Irre führen lässt ‑ durch eigene kognitive Verzerrungen oder durch externe Manipulation.

In der Psychologie wird das menschliche Denken in zwei Systemen unterschieden: System 1 beschreibt die Intuition und System 2 das analytische Denken (vgl. Kahnemann 2011: 33). Während das analytische System bewusst, kontrolliert und langsam funktioniert, ist das intuitive System unkontrolliert, assoziierend und schnell, da nur wenige kognitive Ressourcen beansprucht werden. Eine der wesentlichen Funktionen von System 2 ist die Steuerung der Gedanken und Handlungen von System 1; einige werden direkt im Verhalten ausgedrückt, andere werden unterdrückt oder modifiziert (vgl. Kahnemann 2011: 61). Folgende Denkaufgabe soll das Zusammenspiel beider Systeme veranschaulichen:

Ein Baseballschläger und ein Ball kosten zusammen 1,10 Euro. Der Schläger kostet 1 Euro mehr als der Ball. Wie teuer ist der Ball?

In zahlreichen Experimenten mit Studierenden gab mindestens die Hälfte der Befragten die falsche Antwort an ‑ 10 Cent. Ein schnelles intuitives Vorgehen führt zu diesem Ergebnis, aber die richtige Lösung (5 Cent) findet sich in keiner assoziativen Verknüpfung. (vgl. Kahnemann: 61f.) Diese kann nur analytisch hergeleitet werden, insbesondere, da das Gehirn das Wort „mehr“ verarbeiten muss (vgl. von Nitzsch 2002: 15).

Betrachtet wird weiterhin folgendes logische Argument:

Alle Rosen sind Blumen.

Einige Blumen verwelken schnell.

Deshalb verwelken einige Rosen schnell.

Die zuvor befragten Studierenden stuften diese Schlussfolgerung als gültig ein. Sie erscheint zwar plausibel, ist jedoch nicht stichhaltig, da Rosen nicht zwingend unter den verwelkenden Blumen sein müssen. Auch hier wird der Intuition vertraut ‑ ist System 1 beteiligt, kommt die Schlussfolgerung zuerst und dann folgen die Argumente.

Unbeabsichtigte Fehlschlüsse können aus kognitiven Verzerrungen (bias) oder aus Heuristiken resultieren. Beide sind auf das Zusammenspiel von automatischem und reflektierendem System zurückzuführen. Heuristiken sind verkürzte kognitive Mechanismen, die ressourcensparend zu Schlussfolgerungen führen, in dem sie auf Erfahrungswerte zurückgreifen. Dies führt häufig zu systematischen Verzerrungen und falschen Einschätzungen.

Verfügbarkeit

Geht es um die Einschätzung von Risiken und den Umgang mit Gefahren, setzen viele Menschen die Verfügbarkeitsheuristik ein. Dabei wird auf Ereignisse zurückgegriffen, die im Gedächtnis besonders leicht verfügbar sind. Kann kein Ereignis oder Beispiel herangezogen werden, werden Wahrscheinlichkeiten als sehr gering eingestuft. So verursachen beispielsweise Schlaganfälle nahezu doppelt so viele Todesfälle wie die Gesamtheit aller Unfälle, aber 80 Prozent der Probanden einer Studie zu Verfügbarkeitsfehlern stuften einen Unfalltod als wahrscheinlicher ein (vgl. Kahnemann 2011: 174). Ein Terrorangriff wie 9/11 wird für bedrohlicher erachtet als weniger vertraute Risiken, wie Sonnenbaden unter UV-Strahlung. Allgemein sind Terroristen heute die bedeutendsten Praktiker hinsichtlich der Fähigkeit, Verfügbarkeitskaskaden auszulösen ‑ System 1 wird hier direkt angesprochen (vgl. Kahnemann 2011: 180). Darüber hinaus spielt die Vorstellungskraft bei der Urteilsbildung eine wichtige Rolle: Hat jemand einen Tornado miterlebt, wird ein solches Ereignis für wahrscheinlicher empfunden, als wenn über dieses in den Medien berichtet wird. Außerordentliche Ereignisse, wie zum Beispiel Lebensmittelvergiftungen, ziehen grundsätzlich unverhältnismäßig viel Aufmerksamkeit auf sich und werden demnach als weniger ungewöhnlich wahrgenommen, als sie es tatsächlich sind (vgl. Kahnemann 2011: 174ff.).

Framing

Unterschiedliche Darstellungsformen derselben Information lösen häufig verschiedene Emotionen aus. Die Aussage „Die Überlebenswahrscheinlichkeit liegt im ersten Monat nach der Operation bei 90 Prozent“ ist beruhigender als das Äquivalent „Die Sterblichkeit liegt innerhalb des ersten Monats nach der Operation bei 10 Prozent“. (Kahnemann 2011: 115) Derartige Framing-Effekte funktionieren, da Menschen in ihrer Entscheidungsfindung oft passiv sind und nicht hinterfragen, ob die Entscheidung eine andere gewesen wäre, wenn nur die Frage anders formuliert gewesen wäre. Hier greift also erneut das System 1 ‑ die Intuition. Gleiches gilt für die Angst vor Flugzeugabstürzen: „Bei einer Airline kommt es, wenn man einmal im Jahr fliegt, im Durchschnitt alle 1000 Jahre zu einem Absturz“. Ändert man den Satz um: „Im Durchschnitt kommt es bei einem von 1000 Flügen zu einem Absturz“, hört sich die Formulierung riskanter an. In beiden Fällen liegt die Gefahr für einen Absturz bei 1:1000. (vgl. Taleb 2007: 84f.)

Der Umgang mit Wahrscheinlichkeiten

Besonders gefährlich sind Fehlschlüsse aufgrund von fehlerhafter Interpretation der Wahrscheinlichkeiten und Risiken; ebenso bieten diese bedeutendes Manipulationspotential. Ein bekanntes Beispiel ist die Eilmeldung, die das britische Komitee für Arzneisicherheit 1995 herausgab: „Die Antibaby-Pillen der dritten Generation verdoppeln das Thromboserisiko, d.h. sie erhöhen es um 100%.“ (Gigerenzer 2013: 16f.). Diese Nachricht führte aufgrund des übereilten Absetzens zu zahlreichen ungewollten Schwangerschaften und Abtreibungen ‑ auch wenn diese ein größeres Thromboserisiko als die Pillen der dritten Generation bergen (vgl. Gigerenzer 2013: 16). Entscheidend ist hier die Kommunikation einer 100-prozentigen Steigerung – was genau sind 100 Prozent? Die Studien, auf denen die Meldung basierte, hatten gezeigt, dass sich das Risikolevel von der zweiten zur dritten Generation von 1/7000 Frauen auf 2/7000 Frauen erhöhte. Demnach betrug die absolute Risikozunahme nur 1 von 7000, die relative Risikozunahme lag jedoch bei 100 Prozent. Wäre ausschließlich das absolute Risiko kommuniziert worden, wäre die Meldung ‑ sehr wahrscheinlich ‑ ignoriert worden (vgl. Gigerenzer 2013: 17f.)

Beide Beispiele veranschaulichen, dass der Mensch sich oftmals durch Heuristiken und Intuition fehlleiten lässt. Gleichzeitig werden Wahrscheinlichkeiten ‑ insbesondere von Experten ‑ selten verständlich erklärt. Eine Reflexion über die zu Grunde liegenden Daten (handelt es sich um relative oder absolute Angaben? Was sind 100 Prozent?) würde einen sensibleren Umgang mit Wahrscheinlichkeiten und der Einschätzung von Risiken gewährleisten.

Überdurchschnittlich

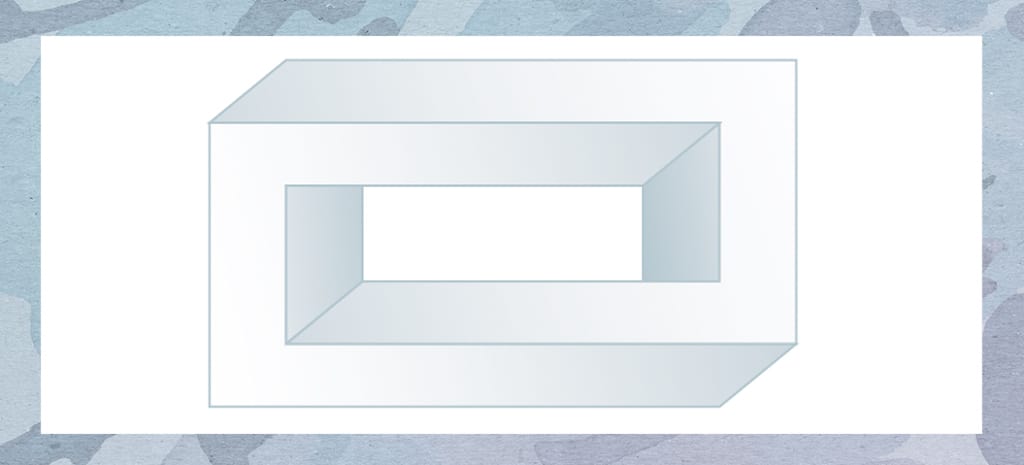

Welcher Tisch ist der größere?

Die meisten Menschen denken, der rechte Tisch sei schmaler und länger als der linke Tisch. Das Seitenverhältnis beim rechten Tisch wird auf etwa 3:1 und beim linken auf ungefähr 1,5:1 geschätzt. Das stimmt jedoch nicht – sowohl die Tischbeine als auch die Ausrichtung fördern die Illusion, dass die Tischplatten verschiedener Größe sind. Diese Illusion wird dadurch verstärkt, dass vertikale Linien länger erscheinen als horizontale.

Nachdem Sie selbst nachgemessen haben, wissen Sie (System 2), dass die Tische gleich groß sind. Aber die Tische erscheinen immer noch unterschiedlicher Größe zu sein (System 1). Durch einen Willensentschluss kann die eigene Wahrnehmung nicht so verändert werden, dass die Tische als gleich groß angesehen werden, obwohl Sie wissen, dass Sie es nicht sind.

Einer der zahlreichen psychologischen Wahrnehmungsverzerrungen, die Menschen aufweisen, ist die Selbstüberschätzung. Die sogenannte Überlegenheitsillusion, positive Eigenschaften zu überschätzen und negative zu unterschätzen, ist eng mit dem Gedächtnis verknüpft (vgl. Shaw 2016: 159ff.). In der Psychologie beschreibt der Above-Average-Effekt die menschliche Tendenz, sich selbst überdurchschnittlich wahrzunehmen. Ungefähr 50 Prozent aller Ehen enden mit einer Scheidung ‑ die meisten Menschen haben von dieser Statistik bereits gehört. Dennoch sind sie unrealistisch zuversichtlich. Die meisten Paare gehen bei der Eheschließung davon aus, dass die Wahrscheinlichkeit einer Scheidung in ihrem Fall etwa null beträgt ‑ auch diejenigen, die bereits eine geschiedene Ehe hinter sich haben. (vgl. Thaler/ Sunstein 2011: 51ff.)

Trugschlüsse, Verzerrungen, Urteilsfehler und Interpretationen ‑ das menschliche Gehirn ist fehlbar. Menschen trauen ihrer Intuition allzu sehr. Verstehen und reflektieren wir aber diese Fehlbarkeit, werden wir weniger von kognitiven Verzerrungen beeinflusst. Das wiederum erlaubt es uns, die eigene Wahrnehmung stärker in Richtung der realistischen Wahrscheinlichkeit zu lenken. Die Schwierigkeit, die das menschliche Denken bereitet, liegt in einem sicheren Fundament begründet: „Unser übermäßiges Vertrauen in das, was wir zu wissen glauben, und unsere scheinbare Unfähigkeit, das ganze Ausmaß unseres Unwissens und der Unbestimmtheit der Welt zuzugeben.“ (Kahnemann 2011: 26)

[su_box title=“System 1“ box_color=“#e4e4e4″ title_color=“#7795a9″ class=“article-infobox-50-left“]

- „Der Apfel fällt nicht weit vom…“

- Wenden Sie sich der Quelle eines plötzlichen Geräuschs zu.

- 2 + 2 = ?

- Fahren Sie mit einem Auto über eine leere Straße.

- Verstehen Sie einfache Sätze.

[/su_box]

[su_box title=“System 2“ box_color=“#e4e4e4″ title_color=“#7795a9″ class=“article-infobox-50-right“]

- 15 * 267 = ?

- Gehen Sie schneller, als Sie es normalerweise tun.

- Fertigen Sie eine Steuererklärung an.

- Wie oft kommt der Buchstabe f auf dieser Seite vor?

- Teilen Sie jemandem Ihre Telefonnummer mit.

[/su_box]

[su_divider top=“no“ divider_color=“#7795a9″ margin=“35″]

Quellen

Gigerenzer, G. (2013): Risiko. Wie man die richtigen Entscheidungen trifft. München: btb Verlag. 5. Auflage 2014.

Kahnemann, D. (2011): Schnelles Denken, langsames Denken. München: Penguin Verlag. 11. Auflage 2012.

Shaw, J. (2016): Das trügerische Gedächtnis. Wie unser Gehirn Erinnerungen fälscht. Frankfurt am Main: Büchergilde Gutenberg.

Taleb, N. (2007): Der schwarze Schwan. Konsequenzen aus der Krise. München: Deutscher Taschenbuchverlag. 4. Auflage 2015.

Thaler, R./ Sunstein C. (2011): Nudge. Wie man kluge Entscheidungen anstößt. Berlin: Ullstein Buchverlage. 10. Auflage 2017.

Von Nitzsch, R. (2002): Entscheidungslehre. Wie Menschen entscheiden und wie sie entscheiden sollten. Aachen: Verlagshaus Mainz. 9. Auflage 2017.